Сексизм і расизм. Чому ІЇ не можна показувати фото Трампа по пошуковому слову idiot

"Штучний інтелект (ШІ) може виявитися сексистом і расистом", - попереджає журнал Nature. До такої думки прийшли Джеймс Цзоу і Лонда Шибенгер з Стенфордського університету. Вчені вивчили величезний масив спотворень, які допускаються ІІ, радять колегам-комп'ютерникам вивчити джерела упередженості і подумати над тим, як її уникнути.

Наприклад, коли Google Translate перекладає новини з іспанської на англійську, пряма мова, що виходить від жінок, подається у формі "він сказав" - в іспанському, на відміну від англійської, займенники можуть вживатися не з дієсловом, і за замовчуванням перекладач ставить "він".

Ще один приклад, наведений дослідниками, - з області розпізнавання зображення. Коли зображення трохи нечітке, представники азіатської раси майже приречені опинитися на фото з закритими очима.

Це досить нешкідливі приклади. Можуть бути ситуації гірше. Наприклад, коли ІЇ допомагає поліції розпізнавати у вуличній юрбі потенційних правопорушників.

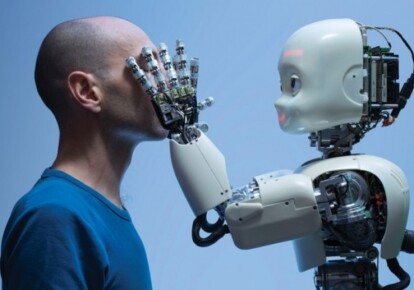

Враховуючи те, що А. стає все більш популярним інструментом прийняття рішень, які стосуються людей, - від моделювання поведінки на вулиці до вибору майбутнього співробітника з безлічі кандидатів на вакансію, - упередженість цього інструменту може виявитися серйозним викликом. Погодьтеся, досить несподіваним. Ми, навпаки, сподівалися, що ШІ виявиться ідеальним інструментом, позбавленим наших людських слабкостей. Раціональним і безпомилковим. І за це, до речі, багато хто свідомо його не злюбили.

Але, виявляється, (майже) ніщо людське ІІ не чуже. І цьому не доводиться дивуватися, враховуючи те, як збираються, обробляються і організовуються дані для навчання ІІ.

Саме тут, вважають Цзоу і Шибенгер, зарита собака. Знову нічого дивного - чи не так? На чому нас вчать - на те ми і віримо. Так от, навчання нейронних мереж відбувається на масивах картинок з підписами, і текстів, зібраних в інтернеті. Популярністю користуються зображення Google і новини Google, де зображення і слова співвідносяться з умовами запиту, або на матеріалі Wikipedia. Ці масиви даних збираються, а потім аннотируются - часто студентами-старшокурсниками або з допомогою краудсорсинговых платформ. Така методика, переконані дослідники, ненавмисно призводить до того, що ШІ згодовують дані, що містять гендерні, етнічні та культурні упередження.

Просто тому, що, наприклад, якісь групи добре представлені в інтернеті, а якісь гірше. Так, більше 45% даних ImageNet, які використовують для досліджень в області комп'ютерного зору, надходять зі Сполучених Штатів, де проживає лише 4% населення світу. У той час як Китай та Індія разом взяті становлять лише 3% даних ImageNet, притому що дані країни - це 36% світового населення. Що в результаті? Штучний інтелект переконаний, що якщо весілля, то жінка одягнена в біле плаття і фату. А якщо на картинці зображена індійська весілля, то ШІ впевнений, що має справу з виставою або етнофестивалем.

Це, зрозуміло, з області курйозів, хоч і говорить дещо про міри упередженості ІІ. Але бувають і серйозніші речі. У минулому році дослідники використовували глибоке навчання для виявлення раку шкіри з фотографіями. Вони навчили свою модель, використовуючи набір даних з 129 450 зображень, з яких 60% були взяті з GoogleImages. Проблема в тому, що менше 5% цих зображень належали темношкірих людей, і алгоритм виявився неефективним для них. Тут мимовільний "расизм" ШІ може мати фатальні наслідки.

"Якщо конкретна група осіб з'являється частіше, ніж інші, у даних навчання, програма оптимізована для цих людей, оскільки це підвищує загальну точність", - пишуть Цзоу і Шибенгер. Навчання виявляється в прямій залежності від того, "кого більше в інтернеті". Загалом, можна, мабуть, припустити, що зображення Дональда Трампа за пошуковому слову idiot може відбитися на поведінкових реакціях деяких видів ІІ.

"Чим більше, тим більше": чим частіше проявляється зв'язок або залежність, тим більше ймовірність того, що ШІ вибере таку залежність за замовчуванням. Якщо в англійській мові співвідношення чоловічих і жіночих займенників становить два до одного, то Google Translate за замовчуванням вибере при перекладі саме "він", якщо займенник не вказано, так як це трапляється при перекладі з іспанської. Але все навіть гірше, тому що таким чином в масиві текстів для навчання перекіс ще більше наростає, збільшуючи частоту вживання саме чоловічого займенники. Що, на думку вчених, ставить під загрозу соціальні досягнення - адже ще в 60-х роках минулого століття це співвідношення становило чотири до одного. І ось штучний інтелект беззвітно рухає нас назад, до початкової точки.

Проблема "упередженості" ІІ відображає досі існуючий дисбаланс, який все більше залишається в історії, але може зробити несподіваний ефект на майбутнє. Так, наприклад, у "Вікіпедії" - найпопулярнішому джерелі освітніх матеріалів для ІІ - менш 18% біографічних записів відносяться до жінок. Статті про жінок частіше посилаються на статті про чоловіків, ніж навпаки. В результаті для пошукових систем чоловіки - популярнішим, ніж жінки. А значить, і більш значущі.

Дослідники переконані, що такий стеоритипизации ІЇ можна уникнути, якщо взяти до уваги дисбаланс, неминучий при користуванні випадковими наборами даних з інтернету. Набори для навчання повинні бути збалансованими за ознакою статі та етнічної приналежності. Загалом, не варто "годувати" ІІ чим попало. Програми навчання потрібно складати ретельно - не тільки для людей, але і для машин. Інакше з машинами обов'язково наступити на ті ж граблі, що і з людьми.

Ще один цікавий висновок з дослідження стэнфордских вчених - про багатство і бідність в інформаційну епоху. "Доступ" - найголовніше слово сучасності. Ви можете бути меншістю, але якщо ви багаті - у вас необмежений доступ та можливість широко розкинутися в інформаційному просторі, - то стаєте в певному сенсі "більшістю", на яке орієнтуються і працюють найсучасніші інструменти.

Висновок з цього простий: якщо ви незадоволені якістю перекладу Google Translate, то це не вина ІІ. Це проблема малої кількості текстів на вашій мові в інтернет-просторі. Пишіть більше. І не англійською, а на рідному.

Почасти у цьому дослідженні ми також отримали відповідь на тривожний допитливі розуми питання: буде штучний інтелект схожий на наш, чи ні? Так от, не просто буде схожий, він стає квінтесенцією всієї історії наших цінностей, уявлень, упереджень, страхів. Адже це не окрема гілка еволюції - це наше творіння. І воно несе в собі відбиток своїх творців.

Штучний інтелект, створений в рамках кожної з культур, буде "представником" своєї культури, і тільки в цьому випадку він може бути використаний для деяких видів завдань. Наприклад, для тотального стеження в Китаї не підійде ІІ, навчений на корпусі ліберальних текстів, маркованих як позитивне все те, що суперечить істинному конфуцианскому духу. Тому ШІ не стане планетарним розумом. У всякому разі на першому - суто прикладному - етапі. І навряд чи він стане воювати проти людини на наступних етапах. Швидше його метою стануть брати по штучного розуму, виховані на інших цінностях та витрачають цінні енергоресурси на те, що буде маркована "шкідливим" або "непотрібним". Люди ж виявляться всього лише випадковими жертвами війн між ШІ, увібрав в себе цінності, уявлення, ідеї і упередження кожної з культур.