Технології обману. Як нейромережі створюють фальшиві особистості громадян і політиків

Майже будь-яка технологія може використовуватися не лише з добрими, а й з поганими намірами. Це стосується і штучного інтелекту

Ледь не щодня ми читаємо про нові досягнення нейронних мереж, які навчаються діагностувати хвороби, створювати нові ліки, шукати корисні копалини та керувати автомобілями. Але водночас нейромережі вдосконалюють своє вміння обманювати людей і одна одну.

"Привіт, це я"

Почнемо з того, як штучний інтелект може підміняти нас, розмовляючи з кимось нашим голосом. Ми звикли, що наш голос — це фундаментальна частина нашої особистості. Недарма голос називають "слуховим обличчям" людини. Але, на жаль, людський голос не настільки унікальний, як хотілося б.

Останні досягнення в області глибокого машинного навчання викликали появу широкого спектру інструментів, здатних імітувати голос конкретної людини. В руках зловмисника такий інструмент може завдати чималої шкоди.

Зокрема, він міг би обійти системи автентифікації на основі голосу, які вже розгорнуті в автоматизованих телефонних лініях обслуговування клієнтів (наприклад, у найбільшому американському банківському холдингу JP Morgan Chase і найбільшому британському банку HSBC), так само як і в деяких мобільних сервісах для обміну повідомленнями (наприклад, у китайській платформі WeChat). Це також порушить контроль доступу на основі голосу користувачів у пристроях IoT (Інтернету речей), таких як цифрові домашні помічники (наприклад, Amazon Alexa, Google Home).

Крім того, такі інструменти можуть обдурювати безпосередньо людей, доповнюючи традиційні фішингові шахрайства знайомим людським голосом. The Wall Street Journal розповіла, як у березні 2019 р. шахраї використали імітований нейромережею голос керівника німецької компанії, щоб змусити керівника дочірньої британської компанії терміново переказати 220 тис. євро якійсь угорській фірмі. Британець був переконаний, що говорить з німецьким босом, бо чітко впізнав його акцент і мелодію його голосу.

Звісно, хотілося б сподіватися, що подібні шахрайства не набудуть широкого поширення, оскільки вони складні в технологічному плані. Чи це так, з’ясувала команда дослідників з Чиказького університету. Свої результати вона оприлюднила у вересні 2021 р. У фінансуванні дослідження взяли участь NSF (Національний науковий фонд США) і DARPA (Агентство передових оборонних дослідницьких проектів Міноборони США). Їх ця проблема, схоже, лякає всерйоз.

Чиказькі дослідники поставили себе на місце зловмисника, який хоче зімітувати чийсь голос. Для цього потрібні три кроки, які вони змалювали у своїй статті. Передусім зловмисник отримує голосові зразки від жертви — або шляхом таємного їх запису, або шляхом завантаження доступних носіїв. Потім зловмисник використовує систему синтезу мовлення для створення фальшивої промови, яка імітує голос жертви. Третій крок — зловмисник використовує цю фальшиву промову, щоб видавати себе за жертву, наприклад, намагаючись отримати доступ до особистої чи фінансової інформації або здійснити якесь шахрайство.

Дослідники використали записи голосів 90 людей з публічних датасетів VCTK, LibriSpeech і SpeechAccent. Загальна довжина запису одного голосу — не більше 5 хвилин. Для створення фальшивих промов було використано загальнодоступні алгоритми SV2TTS і AutoVC. Дослідники випробували ці промови, щоб ввести в оману сучасні системи розпізнавання Resemblyzer і Microsoft Azure. І ось результат експерименту: "Використовуючи комплекс всебічних експериментів над 90 різними мовцями, ми з’ясовуємо, що інструменти синтезу мовлення на основі нейромереж є високоефективними для введення в оману сучасних систем розпізнавання мовців (50-100% успіху)".

Також дослідники спробували обдурити системи WeChat та Amazon Alexa. Ці системи пов’язані з індивідуальними обліковими записами, тому для експерименту було запрошено 14 добровольців. Вони намагалися увійти у власні облікові записи, використовуючи синтезовані зразки мовлення. Alexa був обдурений усіма людьми, а увійти у WeChat вдалося 9 з 14 учасників експерименту.

Крім того, 200 добровольців взяли участь в опитуванні, проведеному з метою оцінити здатність людей розрізняти справжніх і підроблених мовців. Виявилося, що людська точність — на рівні 50%.

Загальний висновок дослідження: "Наші результати демонструють, що синтетичне мовлення, створене за допомогою загальнодоступних систем, вже може обдурити як людей, так і сучасні популярні програмні системи, і що існуючих захисних засобів недостатньо".

Обличчя-відмички

Дедалі частіше ми стикаємося з системами біометричної автентифікації за рисами обличчя. Вони застосовуються у таких сферах, як прикордонний контроль, обслуговування та реєстрація пасажирів, допуск в офісні приміщення, робота з електронними ідентифікаційними документами та картками. Розпізнавання обличчя — це також модний тренд в авторизації користувачів смартфонів. Крім того, системи розпізнавання обличчя дуже популярні у різноманітних державних і приватних служб, що слідкують за громадською безпекою. Цьому сприяє зростаюче використання відеокамер у місцях скупчення людей, таких як вулиці та площі, аеропорти, залізничні та автовокзали.

Але наскільки надійно ідентифікують людей такі системи? Цим питанням зацікавилися дослідники з Тель-Авівського університету. Їхню роботу профінансувала Європейська дослідницька рада (ERC) в рамках програми досліджень та інновацій Європейського Союзу Horizon 2020.

Про свою роботу ізраїльські дослідники відзвітували у серпні 2021 р. Вони розробили нейронну мережу StyleGAN, здатну генерувати обличчя-відмички для систем розпізнавання. В якості бази даних вони використали загальнодоступне сховище Labeled Faces in the Wild (LFW) Університету Массачусетсу, яке містить понад 13 тис. зображень облич. Перед StyleGAN було поставлено завдання, використовуючи обличчя з LFW, створити невеличку кількість, менше десятка, "узагальнених облич", які можна було б використовувати як відмички для систем розпізнавання облич. Для цього було розроблено три методи.

Роботу нейромережі було випробувано на трьох загальнодоступних системах розпізнавання облич: Dlib, FaceNet і SphereFace. Для кожної з цих систем нейромережа генерувала дев’ять "узагальнених облич". Після цього перевірялося, скільки облич з бази даних LFW система визначить як ідентичні одному з цих "узагальнених облич".

І ось результат тестування для методу, який виявився найкращим: Dlib — 63,92%, FaceNet — 43,82%, SphereFace — 44,15%. Ці цифри означають, що всього лише дев’яти облич-відмичок достатньо, щоб обдурити системи розпізнавання облич приблизно у половині випадків (44-64%).

"Наші результати свідчать про те, що автентифікація на основі обличчя є надзвичайно вразливою", — резюмували дослідники.

Як обдурити "старшого брата"

Зворотній бік цієї проблеми — чи може людина змінити своє обличчя до невпізнанності, наприклад, щоб її не ідентифікувала жодна система відеоспостереження жодної служби громадської безпеки. Цю можливість дослідила ізраїльсько-японська команда дослідників з Університету ім. Бен-Гуріона та NEC Corporation. Свої результати вона оприлюднила у вересні 2021 р.

Дослідники шукали технологію, яку кожна людина могла б використовувати багаторазово, ледь не щодня. Тому вони відкинули радикальні варіанти зміни зовнішності на кшталт хірургічного втручання і обмежилися нанесенням гриму. А от завдання підібрати грим доручили нейромережі.

Нова технологія передусім визначає ті частини обличчя, які найчастіше зчитує система розпізнавання. Далі нейромережа підбирає спеціальний макіяж, який допоможе обдурити систему. Цей процес складається з кількох етапів.

Спочатку алгоритм зчитує кілька фотографій людини та випадкових людей однієї з нею статі. Потім нейромережа складає карту обличчя, де зазначає основні області, які є відмінними рисами конкретної людини. Далі на основі карти створюється віртуальне обличчя, на яке наноситься віртуальний макіяж. Це обличчя знову пропускають через систему розпізнавання, і це повторюється кілька разів, аж доки система не перестане впізнавати обличчя. Потім цей віртуальний результат відтворюють у справжній реальності, тобто справжній грим наносять на справжнє обличчя.

Дослідники перевірили ефективність такої технології зміни зовнішності на 20 добровольцях (10 жінок і 10 чоловіків), використовуючи систему розпізнавання облич ArcFace. Підсумки експерименту звучать так: "Система розпізнавання облич змогла ідентифікувати учасників лише в 1,22% кадрів (порівняно з 47,57% без макіяжу та 33,73% із випадковим природним макіяжем), що нижче розумного порогу реалістичного робочого середовища". Тобто нейромережа підбирає грим, за допомогою якого можна обдурити систему розпізнавання облич, майже у 99% випадків. Автори відзначають, що їхня розробка обманює не лише системи розпізнавання, а й усіх навколишніх людей. Макіяж виглядає природньо, і людина не виділяється з натовпу.

Війна нейромереж

Протягом останніх п’яти років неабиякого розвитку досягла технологія діпфейків (deepfake). Буквально deep fake перекладається як "глибока підробка", проте сенс терміну deepfake, вибачте за каламбур, набагато глибший. Deepfake — це фейк, створений не людиною, а штучним інтелектом, який пройшов deep learning — глибоке навчання.

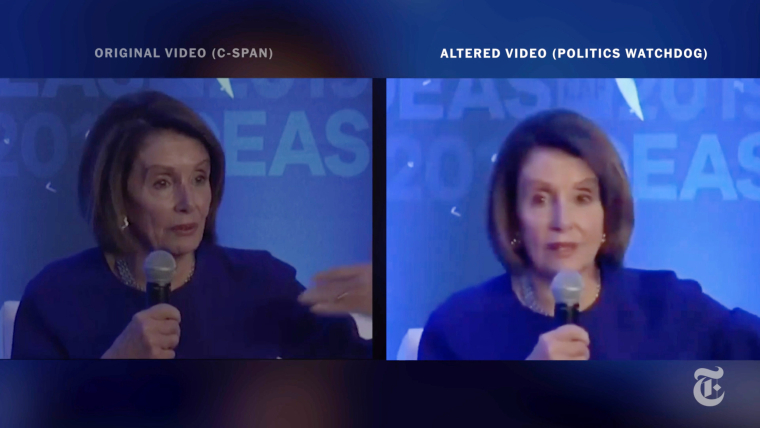

Як і будь які фейки, діпфейки мають різноманітне застосування. Зокрема, їх неодноразово використовували для дискредитації політиків. Наприклад, у травні 2019 р. жертвою діпфейку стала спікер Палати представників Конгресу США Ненсі Пелосі. В соціальних мережах з’явилося відео з "п’яною" Пелосі: реальну відеозйомку її промови було уповільнено, відповідно і сама промова була уповільнена, а голос був пропущений через нейромережу, щоб він звучав, наче природній — як у "справді п’яної" Пелосі. Це відео набрало мільйони переглядів у всьому світі.

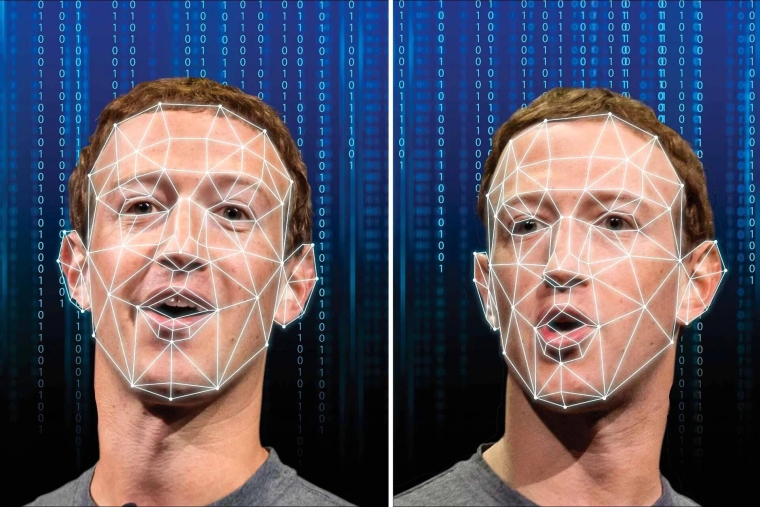

У червні 2019 р. з’явилося відео, де засновник Facebook Марк Цукерберг міркує, як класно володіти даними мільярдів людей. "Той, хто володіє інформацією — володіє майбутнім", — заявив діпфейковий "Цукерберг". Його рухи і міміка були настільки реалістичними, що багато людей повірили у справжність відео. Не дивно, що у вересні 2019 р. Facebook оголосив конкурс алгоритмів, що розпізнають діпфейки, із призовим фондом $10 млн, а на початку 2020 р. оголосив про посилення боротьби з діпфейками, створеними для маніпуляції громадською думкою. Подібні заходи оголосив і Twitter. У вересні 2020 р. Microsoft анонсувала програмне забезпечення Microsoft Video Authenticator, яке дозволяє визначити втручання у відео. Наразі є вже чимало різних класифікаторів контенту, які намагаються виявляти діпфейки.

У діпфейках обличчя суб’єкта змінюється, щоб створити переконливо реалістичні кадри подій, які насправді ніколи не відбувалися. Тому типові детектори діпфейків фокусуються саме на обличчі у відео: спочатку відстежують його, а потім передають ці дані в нейронну мережу, яка визначає, справжнє обличчя чи підроблене. Наприклад, моргання погано відтворюється в діпфейках, тому детектори зосереджуються на рухах очей як на одному зі способів визначити це.

Найсучасніші детектори діпфейків покладаються на моделі глибокого машинного навчання. Тобто нейромережі, які створюють діпфейки, постійно вдосконалюються, і водночас нейромережі, які виявляють діпфейки, теж постійно вдосконалюються.

Так розпочалася війна штучних інтелектів — і разом з нею гонка озброєнь між творцями діпфейків і розробниками систем для боротьби з діпфейками. Команди, що створюють діпфейки, почали навчати свої нейромережі обдурювати захисні системи.

Звісно, зловмисники своїми успіхами не хизуються публічно. Але їхні можливості спробували оцінити дослідники з Каліфорнійського університету в Сан-Дієго. Вони самі створили нейромережу, здатну обдурювати детектори діпфейків. Свої результати вчені презентували на онлайн-конференції WACV 2021.

Новий алгоритм вставляє у фейкове відео спеціальний шум, який змушує класифікатори контенту визнавати відео оригінальним і не відредагованим. Побоюючись, що технологією скористаються зловмисники, дослідники вирішили її не розсекречувати і повідомили про її принцип роботи лише в загальних рисах. Але вони розповіли про результати тестування своєї нейромережі.

Отже, дослідники перевірили свою технологію за двома сценаріями. Перший — коли зловмисники мають повну інформацію про детектор діпфейків, який треба обдурити. Другий — коли їм відомо лише про модель машинного навчання захисної нейромережі.

У першому сценарії рівень успіху обману перевищив 99% для нестиснених відео, а для стиснених склав 84,96%. У другому сценарії показник успіху становив 86,43% для нестиснених відео та 78,33% для стиснених. Таким чином, дослідження продемонструвало успішний обман найсучасніших детекторів діпфейків.

"Щоб використовувати детектори діпфейків на практиці, важливо оцінити їх ефективність проти супротивника, який знає про ці засоби захисту і навмисно намагається зірвати цей захист, — пишуть дослідники. — Ми показуємо, що сучасні методи виявлення діпфейків можна легко обійти, якщо супротивник має повне або навіть часткове знання про детектор".

Щоб покращити детектори, дослідники рекомендують підхід, відомий як змагальне навчання. Нейромережі зловмисників вдосконалюють своє вміння генерувати діпфейки, які здатні обдурити поточний стан детектора. Тому детектори теж мають невпинно вдосконалюватися, щоб виявляти нові діпфейки.

У цій гонці озброєнь навряд чи хтось здобуде остаточну перемогу. Власне, те саме можна сказати й про усі інші технології обману з використанням штучного інтелекту. Віртуальна реальність просочується і дифундує в нашу справжню реальність, і відрізнити одну від одної ставатиме дедалі складніше.