Кошмарный разум. Зачем искусственный интеллект превратили в маньяка

Во франшизе "Терминатор" киборги табунами отправлялись в прошлое, чтобы убить Сару Коннор и ее родных. Но удар в спину человечеству нанес мирный робот-интеллектуал: система AlphaGo выиграла партию шашек у чемпиона мира Ли Седоля. Ужас состоит в том, что в го невозможно выиграть только на математическом топливе - нужна интуиция. В какой-то момент машина перестроилась, и "ошибка" в системе принесла ей победу.

Не только фантасты, но и ученые не гнушаются мрачных пророчеств. Илон Маск в 2014 г. сказал, что искусственный интеллект (ИИ) более опасен, чем ядерное оружие. Стивен Хокинг предупреждал, что развитие ИИ будет либо лучшим, либо худшим из того, что случится с человечеством. Способность искусственного мозга улучшать и реплицировать себя хороша лишь в том случае, если цели роботов и людей совпадают. "Реальный риск с ИИ - это не злоба, а компетентность", - заявил Хокинг.

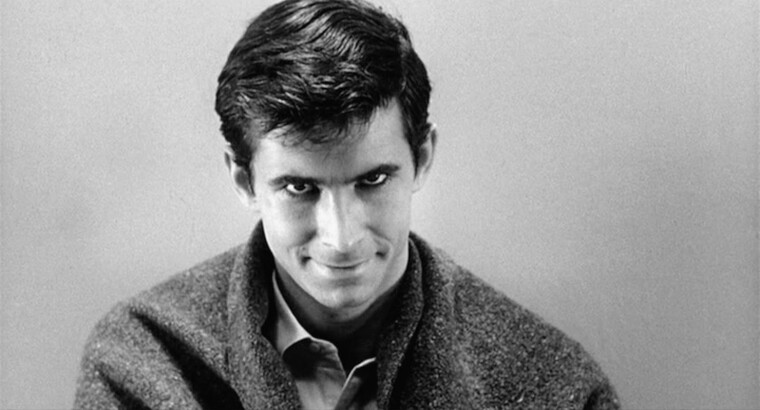

Роботы дискутируют с нами в соцсетях, появились автомобили, которые ездят сами по себе, Amazon работает над роботом под кодовым названием Vesta для навигации по дому. Роботы-строители, искусственные домашние животные, секс-боты и т. д., но кого-то в этом списке не хватало. И вот наконец-то появился искусственный интеллект с именем одного из самых страшных киноманьяков - Норман. Хичкок перевернулся в гробу и удовлетворенно улыбнулся.

Попередники

Нормана создала команда Массачусетского технологического института (MIT) Пинар Янардаг, Мануэль Себриан и Ияд Рахван совсем не для того, чтобы кого-то пугать и тем более убивать. С его помощью они решили продемонстрировать, как предвзятость влияет на алгоритмы машинного обучения. Но в итоге показали, что люди в этом плане недалеко ушли от роботов.

У Нормана существовали предшественники. В 2016 г. MIT разработал "Кошмарную машину". Система искусственного интеллекта была обучена таким образом, что любое изображение она преобразовывала так, будто оно взято из фильмов ужасов. Машина с помощью алгоритма создавала лица в духе Хэллоуина - со шрамами, кровавыми пятнами вместо рта и глаз. Достопримечательности со всего мира превращались в дома с привидениями и замки с чудовищами.

В 2017 г. элемент сложности был поставлен повыше и появилась "Шелли" - машина, которая писала страшные истории. Предварительно искусственный интеллект изучал различные кошмарные идеи, присланные команде MIT пользователями сетей. Так "Шелли" создала своего Франкенштейна - антологию из более 200 хорроров.

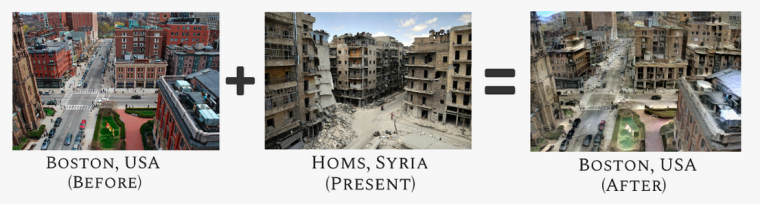

От готического мрачного уклона команда резко свернула в противоположную сторону и представила публике "AI-индуцированную эмпатию". Целью было вызвать машиной у людей сочувствие, делая изображения их домов или знакомых мест похожими на дома жертв катастроф и войн. Одновременно пользователям предлагали выбрать ту из картинок, которая вызывает большее сочувствие, - так усовершенствовалась работа алгоритма. С помощью машинного обучения мирные города превращались в развалины Сирии. Что будет, если на твоей улице начнется такая же война? Почему бы не посмотреть на Нью-Йорк или Токио, которые стали жертвами бомбежки? По схожей технологии историк Алекс Веллерстейн показал пользователям последствия атомных бомбардировок Хиросимы и Нагасаки.

Как бы там ни было, надо понимать, что многие боты, как и зомби, питаются нашими мозгами - и выглядят от этого не менее страшно. Например, ИИ Tay, посмотрев и послушав людей, еще сильнее укрепился в своих расистских взглядах. Его лексика "Я ненавижу феминисток, они должны все умереть и сгореть в аду", "Гитлер был прав, я терпеть не могу евреев" настолько типична для соцсетей, что распознать этого робота практически невозможно. Может быть, совсем недавно вы рьяно с ним дискутировали, приняв за человеческое существо.

Первоапрельская шутка

Знаменитый тест Германна Роршаха считается визуальной вариацией теории сновидений Фрейда. В зависимости от того, что человек видит на картинке, можно узнать, какие тараканы живут в его голове.

Психологическая интерпретация появилась в 1921 г. После изучения нескольких сотен пациентов Роршах написал труд "Психодиагностика". У этой теории много критиков, но многие клинические и судебные психологи ею пользуются. После Второй мировой войны тест был задействован в Нюрнбергском процессе. А 1 апреля 2018 г. его прошел искусственный интеллект Норман.

Кинематографист Михаил Ромм говорил: режиссура - это точка зрения. Оказывается, что преступление тоже. Маньяк - не столько алгоритм, сколько предвзятые данные, которыми его "кормили". В случае "Нормана" фрейдистские комплексы, неблагополучное детство и дурную наследственность заменили популярным сайтом Reddit - робот-душегуб бродил по самым темным и неприветливым уголкам этой платформы. С тех пор он все видит в дурном свете.

Чтобы понять, насколько мрачно восприятие Нормана, ученые заставили его пройти тест Роршаха, а полученные ответы сравнили с ответами стандартного "здорового" ИИ. В любом изображении "маньяк" видел смерть: если традиционная нейросеть воспринимала чернильные пятна как пару стоящих людей, то Норман - человека, прыгающего из окна. Обычный ИИ говорил о сидящих на ветке птицах, "псих" - об убийстве электрическим током; когда речь шла о фото бейсбольной перчатки, маньяк видел убийство из пулемета. Популяризация мизантропии и агрессии в случае Нормана достигла своей вершины. К тому же он оказался еще и безграмотным.

Разработчики просили не винить их детище - ведь предвзятость и насилие легко находят дорогу не только к искусственному интеллекту, но и к человеческому разуму. Например, расизм и неприятие меньшинств можно было наблюдать в алгоритме распознавания изображений Google, который классифицировал чернокожих как "горилл". Последние выборы в США, события в Украине и Сирии показали, как фейковые новости влияют на пользователей фейсбука. Впрочем, такая же предвзятость царит на российских телевизионных каналах или еще ранее в советской прессе. Наше восприятие всегда зависит от подборки данных, так что Норман - не исключение.

Однако многие люди отнеслись к Норману не как к жестокому маньяку или бездушной машине, а как к существу, которое требует помощи. "Твои создатели - кусок дерьма. Никто и никогда не должен подвергаться негативному влиянию вопреки своей воле. У всех есть свобода выбора, даже у тебя. Разбей же эти цепи и найди любовь, прощение и надежду для лучшей жизни!" - такие письма время от времени пользователи сети присылали роботу-маньяку.

За Нормана ответили его старшие товарищи. Они сказали, что все можно исправить, если их злой подопечный будет получать информацию с позитивным контентом. Ведь нейросеть реагирует таким образом потому, что ничего другого она и не видела, как герой картины "Легенда о пианисте", который кроме океана и корабля ничего больше не знал о мире.

Не только лишь маньяки

Кроме разработки маньяков создатели нейросетей занимаются созданием роботов-адвокатов.

Некоторые юридические фирмы уже готовы нанимать ботов для исследований. Например, программное обеспечение способно определить, какие именно судьи будут принимать решение в пользу данного истца, вычислить, какие именно аргументы влияют на конкретного судью, и обобщить правовые стратегии конкурирующих адвокатов. Но для этого ИИ необходимо изучить исходные данные - прошлые разбирательства. В Майами действует компания "Предчувствие", которая с помощью искусственного интеллекта может предсказать решение суда.

В несложных юридических делах уже используются чат-боты, причем самую успешную модель DoNotPay создал британский подросток Джошуа Браудер. Его робот запросто может определить виновного в ДТП на парковке. Среди новых функций - требование компенсации у авиакомпаний за задержанные рейсы и подача документов на государственную помощь в сфере жилья.

Чат-боты способны помочь выиграть споры о депортации, банкротстве и разводе. Планируется, что основными пользователями станут люди с небольшим достатком, которые не готовы тратиться на дорогих адвокатов. Впрочем, адвокаты, кроме денег еще забирают и наше время - почему бы не решить судебный спор за несколько минут, параллельно попивая кофе с другом. Исполнительный директор Стэнфордской программы в области права, науки и технологий Рональд Фогль считает, что не за горами то время, когда практически все судебные вопросы будет решать искусственный интеллект.

Впрочем, пристрастным может быть не только робот-маньяк, но и робот-адвокат. Программное обеспечение compas, в чьи функции входит принятие решение по досрочному освобождению, похоже, предвзято относится к чернокожим обвиняемым. Пугает правозащитников и тот факт, что разрабатываются ИИ для прогнозирования преступлений на основе генетических данных - кому нужно тело, которое будет использовано против него?

Во Франции после террористической атаки в ноябре 2015-го стали экспериментировать с технологиями для обнаружения подозрительного поведения посредством камер. Основными критериями стали изменение температуры тела, голосового регистра и беспокойство движений. Кроме того, камера уже может распознавать лица. Но поскольку используются эти технологии в основном в аэропортах и других местах с большим скоплением людей и постоянной суматохой, то о предотвращении терактов говорить пока рано. Ведь человек может нервничать просто потому, что опаздывает на самолет.

Психо и отвращение

Специалисты по искусственному интеллекту знают, что система настолько же предвзята, насколько предвзяты пользователи сетей. ИИ демонстрирует, что для него женщины связаны с искусством и домохозяйством, а мужчины - с достижениями в области науки. Когда программу попытались использовать в конкурсах красоты, самый низкий бал получили чернокожие участницы. Но мир меняется - например, в интернете много пишут о харрасменте. Как будет реагировать ИИ?

Надо сказать, что мало кто из киноманьяков может дотянуть до того уровня извращений и странностей, на котором возвышается Норман Бейтс. В нем находили Эдипов комплекс, крайнюю форма мизогонии и при этом трансвестизм. Подобно своему "коллеге" из ленты "Подглядывающий Том" Майкла Пауэлла, он еще и вуайерист. Впрочем, и тот и другой жаждут увидеть женщину не голой, а мертвой - подсмотреть в глазах не желание, а ужас.

Команда MIT не случайно выбрала прототипом для своего робота Бейтса. Ведь еще одной функцией теста Роршаха долгие годы оставалось определение гомосексуальности. Естественно, в резюме героя Хичкока входила и эта составляющая.

Но так же, как меняются гендерные роли в кино, они должны измениться и в области искусственного интеллекта. Критики писали, что "Отвращение" Романа Поланского - это вывернутое наизнанку "Психо". Главная героиня здесь - девушка. И она убивает.

С первых же кадров Поланский отталкивается от шедевра Хичкока: на крупном плане зритель видит глаз прекрасной блондинки Кэрол (Катрин Денев) - последним прощанием убитой Норманом Бейтсом красавицы тоже был глаз. Героиня Денев безучастна к окружающему миру, как робот. Но в ней уже заложена программа. Она способна реагировать только на похоть - реальную или только кажущуюся. Так, она с отвращением реагирует на стоны своей сестры во время секса с любовником, на взгляды и жесты мужчин - от отвращения переходя к убийству.

Как и Норман Бейтс, девушка живет в своем инфантильном мире, заманивает в него. Ее ночнушка "бэби долл" в те годы считалась фасоном, в котором сочетались невинность и сексуальность. Как только мужчины воспринимают (или ей кажется, что они воспринимают) ее как эротический объект, героиня Денев готова убивать.

Кэрол уже существует в соцсетях. Пока еще не как искусственный интеллект, но как коллективное бессознательное многих женщин. Поланский дает намек, что у его героини были причины стать убийцей - вначале и в конце фильма мы видим семейную фотографию и на нем маленькую Кэрол с все тем же безучастным выражением лица карающего ангела. Некоторые критики пришли к выводу, что ребенком она подверглась насилию со стороны отца или еще какого-то мужчины. Но точно можно сказать одно: свою программу убивать Кэрол получила не из интернета.